Stable Diffusion паказала АІ-генератар відэа па малюнку або тэксце

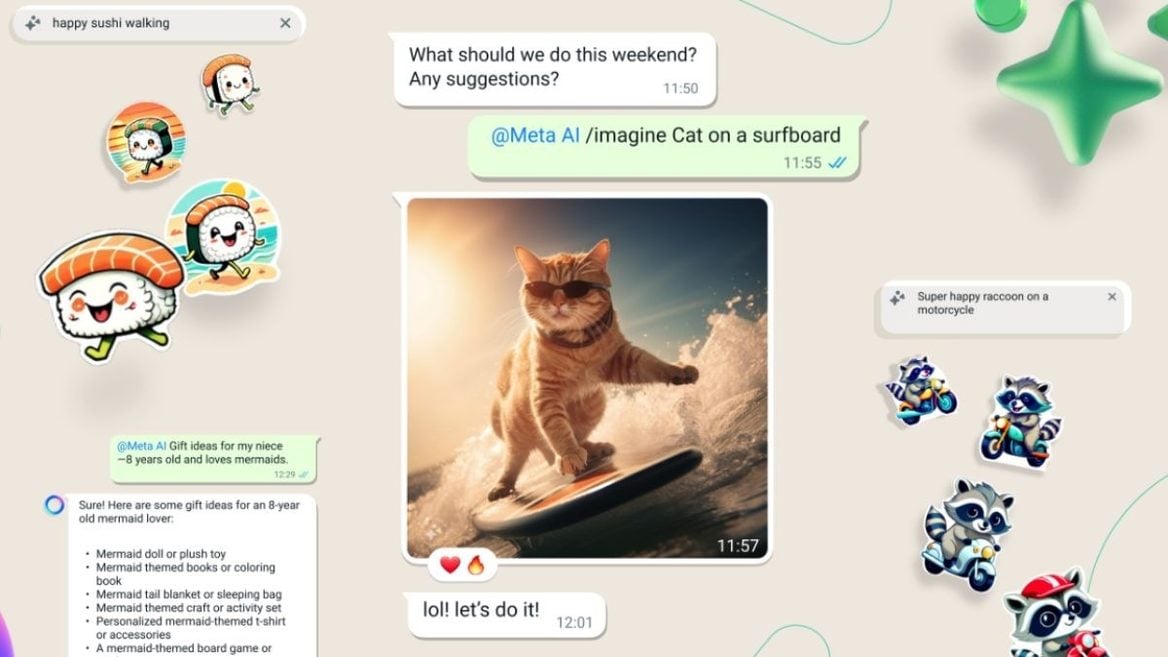

Кампанія паказала генератыўную мадэль Stable Video Diffusion, прызначаную для стварэння відэаролікаў па тэкставым апісанні.

Кампанія паказала генератыўную мадэль Stable Video Diffusion, прызначаную для стварэння відэаролікаў па тэкставым апісанні.

Кампанія паказала генератыўную мадэль Stable Video Diffusion, прызначаную для стварэння відэаролікаў па тэкставым апісанні.

Stable Video Diffusion выпушчаная ў выглядзе двух мадэляў пераўтварэння выяў у відэа. Першая генеруе па адной выяве памерам 576×1024 пікселяў 14 кадраў, другая — 25 кадраў. З іх можна зрабіць відэа з частатой кадраў ад 3 да 30 на секунду. Пакуль мадэль не прызначаная для стварэння поўнафункцыянальных або камерцыйных праграм.

У аснову сэрвісу легла мадэль Stable Diffusion, якая генеруе статычныя выявы на аснове тэкставых запытаў. Зыходны код распрацоўшчык апублікаваў на GitHub, неабходныя для лакальнага запуску даныя даступныя для спампоўкі на Hugging Face. Таксама кампанія выклала даследчы матэрыял, у якім выклала тэхнічныя магчымасці мадэлі.

Мадэль адаптуецца для розных задач: напрыклад, яе можна наладзіць для генерацыі відэа па адной выяве ў якасці ўзору. Stable Video Diffusion стане базавай платформай для сямейства вытворных мадэляў, якія будуць выходзіць пазней. Кампанія плануе пабудаваць цэлую экасістэму сэрвісаў.

У будучыні распрацоўшчыкі пакажуць магчымасць генераваць відэа па тэкставым апісанні ў вэб-інтэрфейсе. Карыстальнікам трэба аформіць заяўку на ўключэнне ў спіс чакання.

Рэлацыраваліся? Цяпер вы можаце каментаваць без верыфікацыі акаўнта.