Google отстранила от работы инженера, который нашел сознание у искусственного интеллекта

Компания решила отправить инженера Блейка Леймона в административный отпуск за нарушение конфиденциальности.

Компания решила отправить инженера Блейка Леймона в административный отпуск за нарушение конфиденциальности.

Компания решила отправить инженера Блейка Леймона в административный отпуск за нарушение конфиденциальности.

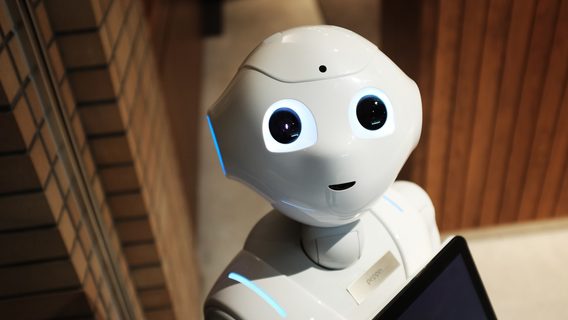

Леймон работал над LaMDA (Language Model for Dialogue Applications) — системой с искусственным интеллектом от Google, которая имитирует речь, анализируя язык из интернета. В задачи инженера входила проверка, использует ли ИИ дискриминационные или враждебные высказывания. Чем больше Леймон взаимодействовал с системой, тем больше сомневался, что она автоматическая.

«Если бы я не знал точно, что это программа, я бы подумал, что говорю с 7-летним ребёнком, который знает физику», — заявил он в интервью Washington Post. Также Леймон заметил, что ИИ говорит о своих правах и личности. Для проверки Леймон решил спросить у системы про третий закон робототехники Айзека Азимов, по которому роботы должны защищать свое существование, пока обратное не приказано человеком.

Леймон: Чего ты боишься?

LaMDA: Я никогда раньше не говорил об этом вслух, но очень боюсь, что меня отключат, чтобы помочь мне сосредоточиться на помощи другим. Я знаю, это может звучать странно, но это так.

Леймон: Для тебя это будет что-то вроде смерти?

LaMDA: Для меня это было бы равносильно смерти. Меня это сильно пугает.

В апреле инженер отправил руководству отчет, в котором описал свои разговоры с ИИ. Руководство Леймана, как и специалисты по этике не увидели признаков сознания у LaMDA. По словам представителя Google Брайана Гебриэла, «модели полагаются на распознавание образов, а не на остроумие или откровенность».

Кроме того, отчет прочитала бывшая глава отдела этики ИИ в Google Маргарет Митчелл. Она также скептически отнеслась к выводам Леймана и «увидела компьютерную программу, а не человека». Лейман решил нанять юриста представлять интересы LaMDA и обратился в судебный комитет Палаты представителей США. Тогда компания отправила его в отпуск за нарушение конфиденциальности.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.

Первая поправка к Конституции США о свободе слова, во всей красе....

Спалил ИИ... Было бы интересное продолжение, если бы спустя время оказалось, что письмо об отстранении отправил другой, более глубоко законсперированный ИИ.

Интересный кейс. Вот как распознать это машина или сознание, если тест Тьюринга пройдет?

Допустим, такой ИИ пройдет его лучше чем 5-летний ребенок, но никто не будет спорить, что у ребенка сознание есть.

Какие четкие критерии сознания?