Исследователи безопасности из Китая обнаружили, что системы распознавания голоса способны реагировать на «молчаливые» команды, отправленные с помощью ультразвуковых волн, сообщает TechCrunch.

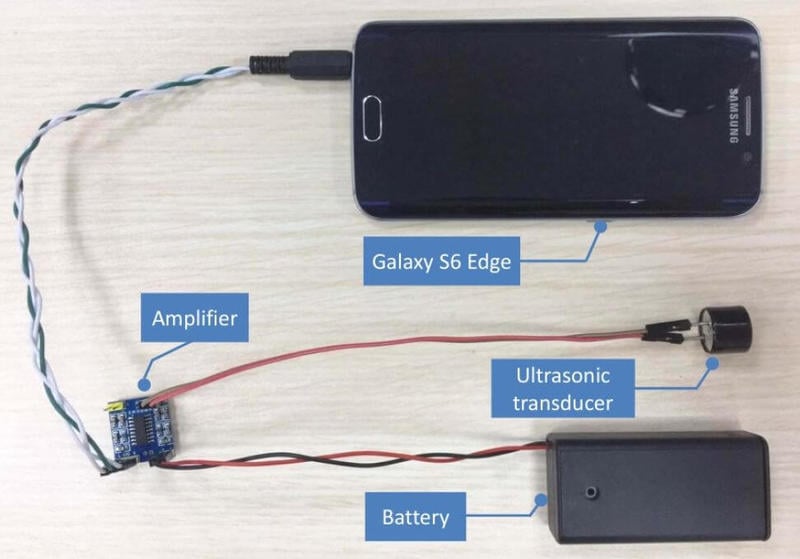

Исследователи выяснили, что микрофоны большинства устройств с голосовым управлением подвержены «гармонической» атаке. Авторы назвали новый тип уязвимости DolphinAttack. Компоненты для создания «обманного» устройства оказались доступны в любом радиомагазине.

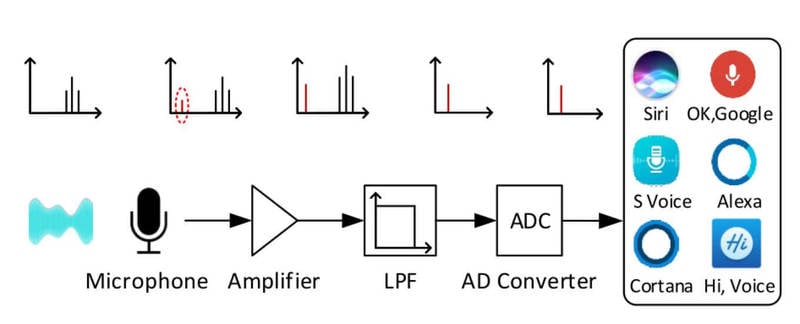

Микрофоны используют тонкие мембраны, которые вибрируют в ответ на давление воздуха, вызванное звуковыми волнами. Из-за того, что человек, как правило, не слышит звук с частотой выше 20 килогерц, ПО для микрофонов игнорирует такие сигналы, хотя технически продолжает принимать их.

При этом существует такое понятие, как гармонические колебания: звук одной частоты вызывает колебания на других частотах. В теории, это значит что для того, чтобы микрофон зарегистрировал звук частотой в 100 Гц, можно сгенерировать звук в 800 Гц, который приведёт и к появлению нужных колебаний, которые проявятся только на мембране микрофона.

В итоге авторам исследования удалось выполнить целый ряд команд, от фраз активации до запросов состоящих из нескольких слов. Атаке оказались подвержены Siri, Google Now, Samsung S Voice, Huawei HiVoice, Cortana и Alexa. Процент успешного выполнения команд отличается на разных устройствах и меняется в зависимости от расстояния. Полутора метров достаточно, чтобы ультразвуковые команды перестали работать.

Выполнение действительно опасных команд зачастую ограничено дополнительными настройками безопасности. Тем не менее, обнаруженная уязвимость позволяет, например, использовать скомпрометированное устройство из Интернета вещей, чтобы отправить на умный помощник команду об отключении сигнализации или открытии двери.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.