Команда Google AI опубликовала алгоритм машинного обучения, который распознаёт жесты в реальном времени. Для вычислений ему не требуются мощные десктопные или облачные среды: он способен работать на мобильных устройствах, пишет TechCrunch.

Сложность распознавания жестов для AI состоит в том, что руки и пальцы могут заграждать друг друга, более того, жестикуляция может быть слишком быстрая и недостаточно чёткая, из-за чего распознавать их точно и мгновенно для алгоритмов очень сложно.

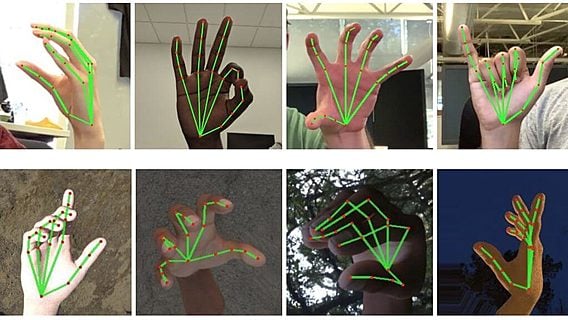

Чтобы ускорить процесс, исследователи решили уменьшить объём данных, которые алгоритм должен обработать. К примеру, они отказались от распознавания руки целиком: вместо этого от системы требуется найти ладонь, после чего проанализировать каждый из пяти пальцев. Отдельный алгоритм фиксирует 21 точку на полученном изображении, расстояние между ними и их взаимное расположение. Таким образом создаётся высокоточная «карта» ладони и пальцев. Причём одновременно алгоритм Google может распознавать несколько рук.

Далее новый распознанный жест сравнивается с базой уже известных жестов — от алфавита и цифр на языке глухонемых до жестов, символизирующих, например, «рок» «мир», «ОК». Для этого исследователи создали датасет из 30 тысяч изображений с руками в разных жестах и под разным освещением, на которых вручную обозначили эту 21 координату.

В результате получился шустрый и точный алгоритм, который поддерживается любым смартфоном. Он работает внутри кроссплатформенного ML-фреймворка MediaPipe, который Google представила в июне. Однако в каких-либо продуктах компании алгоритм пока не задействован.

Документация доступна на GitHub.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.