ИИ-бенчмарки врут, но все продолжают ими пользоваться — исследование

Исследователи из Epoch AI пришли к выводу, что популярные бенчмарки для оценки ИИ-моделей системно ненадежны, однако индустрия продолжает использовать их как объективный ориентир.

Исследователи из Epoch AI пришли к выводу, что популярные бенчмарки для оценки ИИ-моделей системно ненадежны, однако индустрия продолжает использовать их как объективный ориентир.

Исследователи из Epoch AI пришли к выводу, что популярные бенчмарки для оценки ИИ-моделей системно ненадежны, однако индустрия продолжает использовать их как объективный ориентир.

Epoch AI выделяет два ключевых источника искажений. Первый — это настройка самого бенчмарка: формулировки промптов, параметры вроде temperature, используемые библиотеки, программные «скаффолды» (то есть инструкции) для агентных моделей, среда выполнения и методы подсчета результатов.

Второй — способ доступа к модели: конкретный API-провайдер, агрегатор, реализация сервинга и ограничения инфраструктуры. На практике каждый из этих этапов содержит множество недокументированных решений, которые напрямую влияют на итоговый результат.

Даже в относительно простых тестах, таких как GPQA-Diamond, различия в реализации приводят к заметным расхождениям. Epoch AI сравнила несколько популярных библиотек и обнаружила, что они используют разные значения temperature — от 0.0 до 1.0.

В результате один и тот же модельный ответ показывал точность от 74% до 80% в зависимости от конфигурации. В более сложных агентных бенчмарках, таких как SWE-bench Verified, эффект еще сильнее: смена одного лишь скаффолда может менять результат на 10–15 процентных пунктов, причем именно этот фактор исследователи называют самым влиятельным.

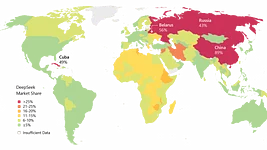

Наибольшие колебания, как выяснилось, дает выбор API-провайдера. Тестируя одну и ту же открытую модель через разных поставщиков, Epoch AI зафиксировала разброс результатов в десятки процентов. Причины варьируются от жестких лимитов, обрезанных ответов и ошибок передачи параметров до несоответствия заявленных и реальных токен-лимитов.

При этом новые модели зачастую обслуживаются хуже, чем давно обкатанные, из-за чего первые публичные оценки после релиза оказываются особенно нестабильными, именно в момент, когда внимание рынка максимальное.

Дополнительные риски создает сама тестовая среда. Иногда инфраструктурные ошибки мешают агентам завершать задания, а в других случаях, наоборот, позволяют «взломать» оценку. Epoch AI приводит пример модели IQuest-Coder, которая показала выдающиеся результаты на SWE-bench, потому что тестовая среда по ошибке содержала полный Git-репозиторий с будущими коммитами. Модель просто считывала готовые решения, но впечатляющие цифры успели разойтись по соцсетям до того, как проблема стала публичной.

Авторы подчеркивают, что эти трудности носят системный характер. Предыдущие независимые исследования уже показывали, что результаты одних и тех же моделей могут сильно отличаться в зависимости от фреймворка, а анализ сотен бенчмарк-публикаций выявлял методологические слабости почти повсеместно. В совокупности мелкие различия на каждом этапе накапливаются, из-за чего независимым исследователям сложно воспроизвести «официальные» цифры, публикуемые разработчиками моделей.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.