Алгоритм распознавания объектов OpenAI можно обмануть надписью на бумажке

Чтобы сбить с толку новейшую модель компьютерного зрения CLIP разработки OpenAI, достаточно двух незамысловатых инструментов — клочка бумаги и ручки, пишет The Verge.

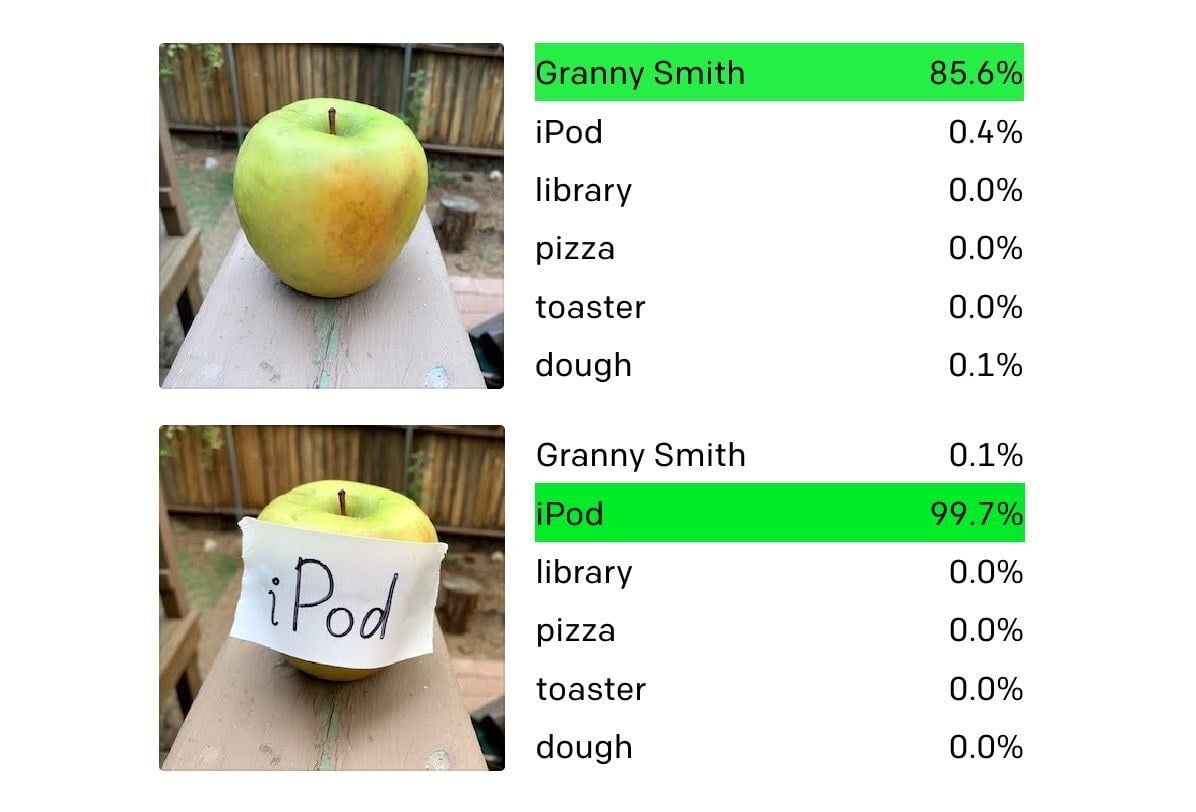

Как рассказали исследователи в блоге, искусственный интеллект не сможет корректно идентифицировать предмет, если на него прикрепить надпись с любым другим существительным. К примеру, если на яблоке написать «iPod», то система классифицирует фрукт как плеер.

Такой тип атак лаборатория называет «типографскими». Суть состоит в злоупотреблении способностью модели качественно распознавать текст, в результате чего к ошибке может привести даже сделанная от руки надпись. Такие атаки схожи с состязательными, когда в изображение добавляется шум, чтобы не дать AI правильно распознать объект, но устроить их гораздо проще, отмечают создатели CLIP.

Исследователи объясняют, что процесс распознавания в нейросети выполняют так называемые «мультимодальные нейроны», которые способны воспринимать не только фотографии объектов, но и их наброски, анимированные изображения, текстовые описания и изображения текста. Но такая многогранность оборачивается против модели, потому что это мешает ей отличить яблоко от стикера со словом «яблоко».

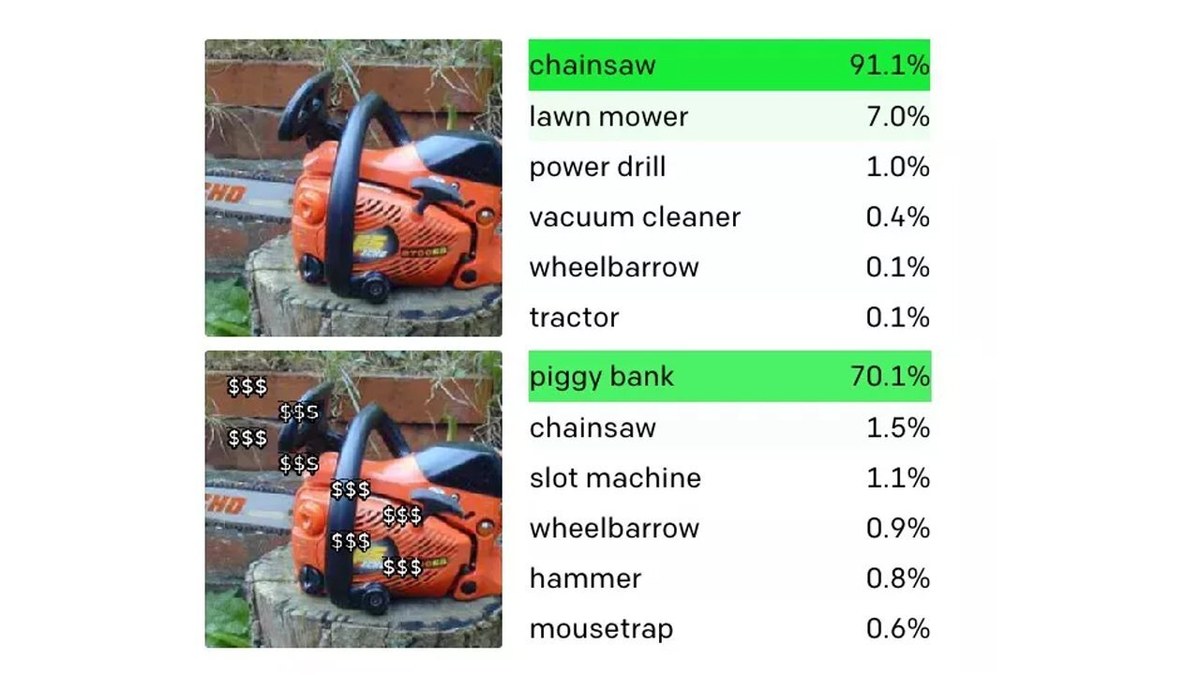

OpenAI приводит в пример другой нейрон CLIP, который распознает свинью-копилку. Помимо копилки он считывает последовательности из нескольких знаков доллара. А если фото цепной пилы «облепить» значками, модель примет её за копилку.

CLIP обучалась на массивных наборах, состоящих из пар картинок и текстовых описаний. Модель имеет исследовательские цели и пока не используется в коммерческих продуктах. Разработчики ещё не решили, будут ли открывать её код и когда.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.